Wi-Fiで画像表示できるスマート缶バッジを作ってみた – 前編

はじめに こんにちは、Cerevoの駆け出し電気エンジニアのたひです。今回が初投稿になります。 交流会や展示会、オフ会などリアルでの交流の場で自身を表すのに名刺交換やX(旧Twitter)のプロフィールなどを見せて合うこ […]

スマホで操作できる改造ミニ四駆「MKZ4」をさらに改造してカメラ付きラジコンに〜社内爆走計画〜

こんにちは PMの後藤です。 Cerevoではミニ四駆を改造してWi-Fiラジコン化するMKZ4という製品があります。今回それをさらに改造して、Wi-FiマイコンとしてポピュラーなESP32にカメラがついたモジュールを利 […]

ガシャポンのカプセルをラジオに電子工作!夏休みラジオ少年計画

こんにちは、Cerevoの押切です、毎日暑いですね。8月ももう半ばですが、今回は夏休み工作的に、初心者でも簡単に作成できるガジェットの作成記事となります。とある理由から、ガシャポンのケースに収まるものというお題で考えてみ […]

BLE Long Rangeってどれくらいロングレンジなの?nRF52840評価ボードで長距離通信実験

こんにちは。PMの後藤です。 Bluetooth5.0になってCoded PHY、または通称Bluetooth Long Rangeと呼ばれる通信モードが使えるようになりました。Coded PHY(Bluetooth L […]

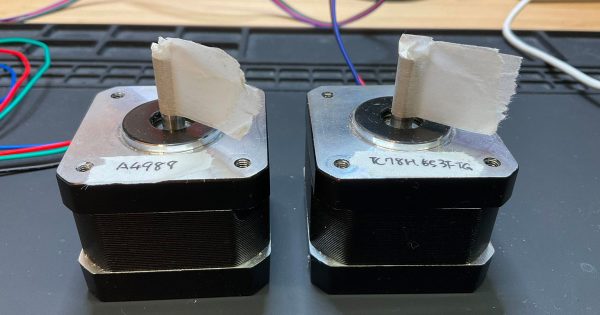

格安モータドライバを使って、すごーくゆっくり静かに回すマイクロステッピングを実装するには?

こんにちは。PMの後藤です。 唐突ですが皆さんはステッピングモータが好きですか?僕は好きです!個人的な制作活動でも何度も使っていますが、 位置制御が非常に簡単に出来て便利です。ただし動作音は結構しますよね。巷では NEM […]

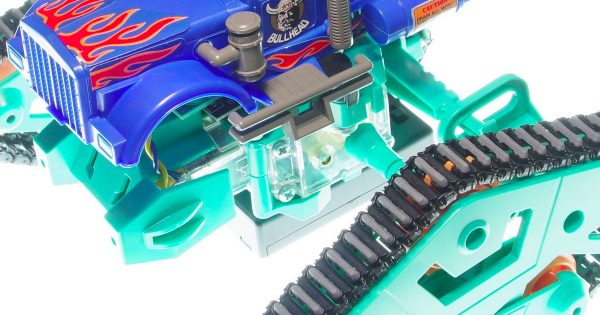

ミニ四駆ツイストクローラーを改造してワイヤレス制御!工作セットとMKZ4で簡単電子工作

こんにちは、押切です。前回の続きという訳ではないのですが…… 左右独立駆動型のクローラー、 楽しい工作シリーズ(セット) No.233 ツイストクローラー工作セット(2chリモコン) で、ワイヤー […]

四輪クローラー工作セットでワイヤレスリモコン化&速度制御に挑戦

こんにちは、押切です。 タミヤさんから、「四輪クローラー工作セット」という魅力的なキットが発売され、かつ、ボディはワイルドミニ四駆のものが使用できるということで早速入手して見ました。 格好いいので早速、スマホで操作できる […]

SoCボード「Orange Pi Zero2(TELEC版)」をAndroido10.0で実装 – 試食編 –

こんにちは、Cerevoの押切です。 随分間が空いてしまいましたが、「ラズベリーがなければ、オレンジを食べればいいじゃない。Orange Pi Zero2(TELEC版)を試食~Androido10.0編~」の続きとして […]

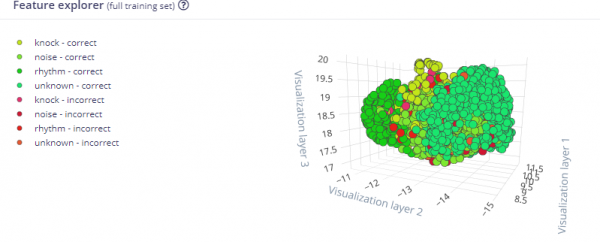

マイコン機械学習で「ひみつのあんごうノック」で開くボックスを作る

こんにちは、9月からCerevoでプロジェクトマネージャーをしている後藤です。 子供の頃に秘密基地を作って遊んだ時、ノックのパターンを決めて「ひみつのあんごう」なんていってましたよね? そんな「ひみつのあんごうノック」で […]

ラズベリーがなければ、オレンジを食べればいいじゃない。Orange Pi Zero2(TELEC版)を試食~Androido10.0編~

こんにちは、オンラインイベントなんかもはじめた押切です。今回は個人的にヒットしたSoCボードについて紹介していきます。 昨今の半導体不足は深刻ですね。商社に頼むと72週待ちですと言われましたが、その部品が届くころ、弊社は […]

ハードウェア量産において避けられないEMC試験に落ちないための心がけ

はじめに こんにちは。電気エンジニアの早川です。最近記事を連投していますが、記事を書くのがなんだか楽しくなってきております。 ラジオの近くで電子機器の電源を入れるとラジオの音声にノイズが入るといった経験がないでしょうか。 […]

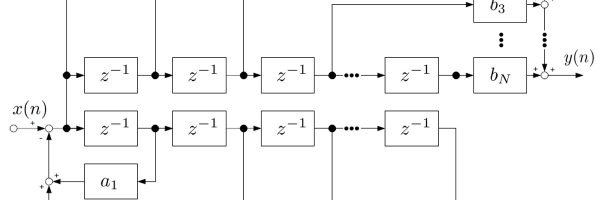

アナログ視点で理解するディジタルフィルタ。FIRフィルタとIIRフィルタの構造とは

はじめに こんにちは。電気エンジニアの早川です。前回、ディジタルフィルタのうちFIRフィルタについての解説を行いました。今回は主にIIRフィルタについて解説したいと思います。 IIRフィルタはアナログフィルタとの共通点が […]

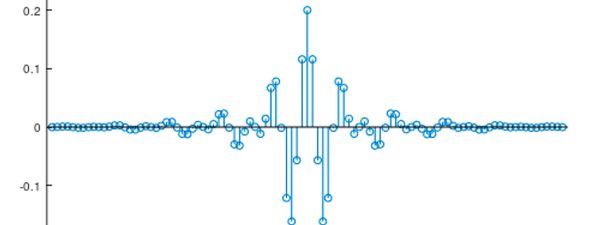

数式をほとんど使わずに理解するディジタルフィルタ

はじめに こんにちは。電気エンジニアの早川です。 組み込みソフトや、音声を扱うソフトなどを書いているとちょっとしたフィルタを仕込みたい場面に遭遇することがあります。こういったディジタルの世界に実装するフィルタのことをディ […]

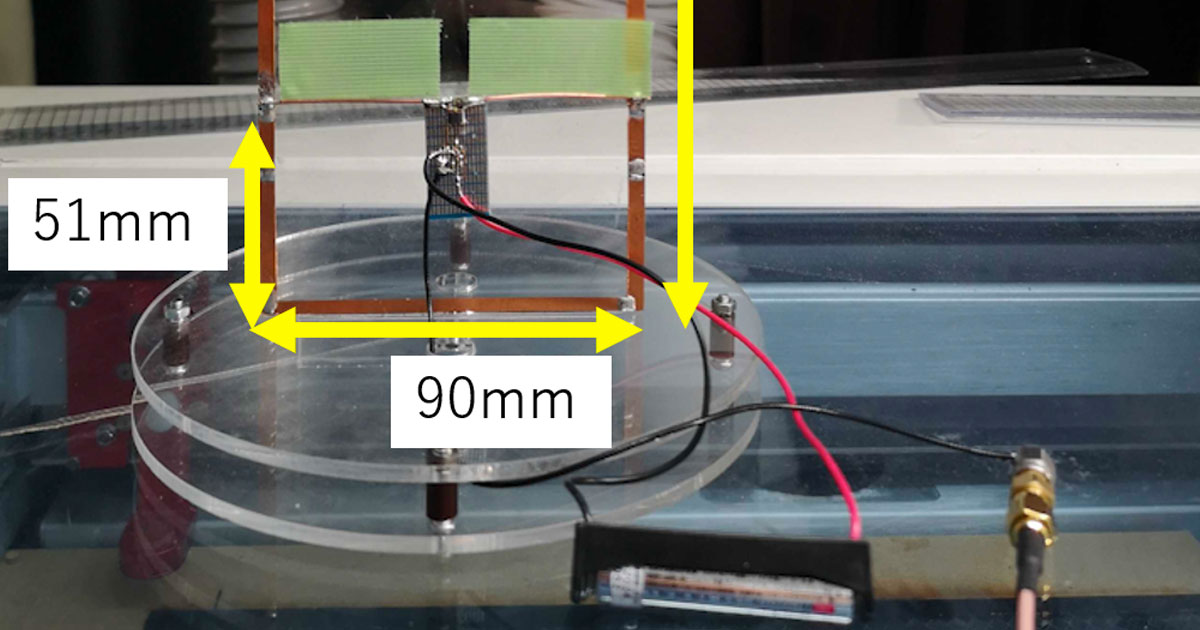

地デジ用室内アンテナの自作と、スペシャルチューン版の制作

こんにちは。電気エンジニアの早川です。最近、電波を扱う案件を担当したこともあり、専門外ではありますが興味の対象がアンテナに向いています。そんなわけで、この記事を書いてみました。 八王子のテレビ受信事情 東京の場合、地上波 […]

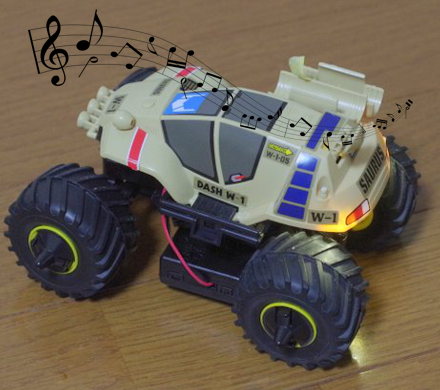

【MKZ4特別企画2】プログラミングでIoT改造ミニ四駆から音楽を鳴らしてみよう

こんにちは、押切です。今年のGWはいかがだったでしょうか。電子工作ははかどりましたか?Cerevoはカレンダー通りの休日ですが、まだ休みの方も多いのではないでしょうか。 今回は、前回に続きスマートフォンから操作できるよう […]