Allwinner、Amlogic、Rockchipって知ってます?[24日目]

本記事は、Cerevoスタッフが業務や趣味について思うままに書き綴るアドベントカレンダー企画「Cerevo アドベントTechBlog 2017」の第24日目です。 Cerevo アドベントTechBlog 2017 h […]

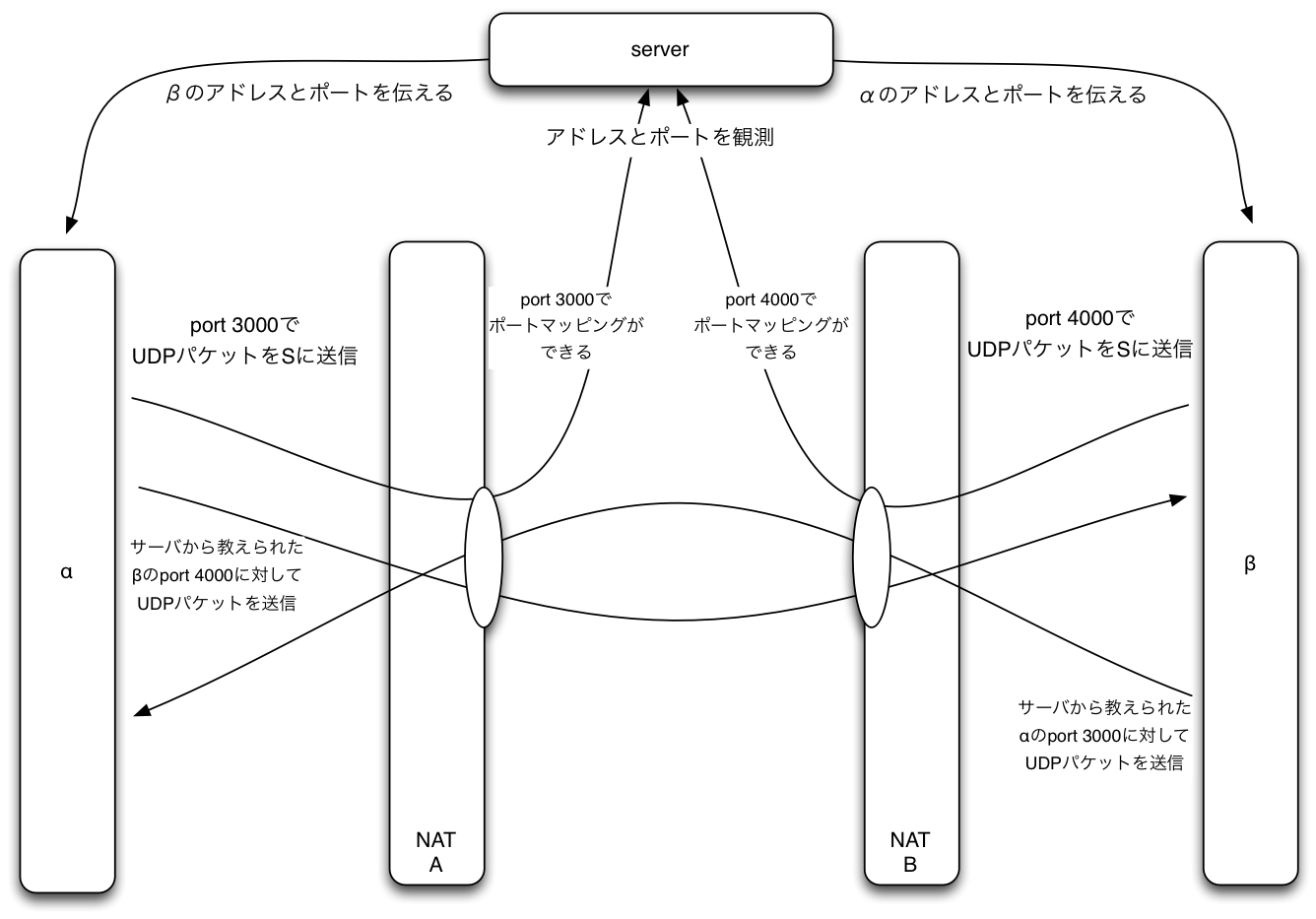

NAT Traversalって知ってますか

Cerevoアドベントカレンダー2016、最終日です。といっても、どうやら大トリは弊社代表が年末までに昨年のネタの更新版を出すようなので、私はトリらしい何かとかでもなく、テックブログらしく技術ネタを書きたいと思います。 […]

[1日目] 高価な市販NASを買わずに、HDDがクラッシュしても大丈夫な運用しやすい社内のファイル共有サーバを構築する方法

唐突ですが、アドベントカレンダーというのを皆さんご存じでしょうか。 アドベントカレンダーとは……本来の意味のほうではなく、ネット上で数年前から行われている企画で、12月1日から24日まで連続して行われるリレーブログのこと […]

LiveShell PROのRTSPサーバー機能を利用して、Wirecastの入力ソースの1つとして扱う方法

まつけんです。 今回は、新たにリリースされた新機能であるLiveShell PROのRTSPサーバ機能を利用して、Wirecastからの利用方法、Windowsの仮想カメラとして認識させる方法等のRTSPサーバの活用方法 […]

LiveShellシリーズ用、インターネット経由操作APIを公開しました

突然ですが、LiveShell/LiveShell PROのDashboard機能を開発者の皆様にも使っていただけるようAPIとして公開しました。 詳しくは、こちらのドキュメントを見ていただければ詳細が書いているので、是 […]

AWSを活用して全国ネット番組(NHK)によるアクセス急増を乗り切った具体的手法

まつけんです。 前回のWBSでの紹介に引き続き、今回はNHK「サキどり」にCerevoを紹介いただける機会に恵まれました。というわけで、前回同様に急激なアクセス増が放送日に集中することが予想されるので、いくつかの負荷対策 […]

EC2とS3をうまく使い分けてワールドビジネスサテライト砲を確実に乗り切る方法

まつけんです。 今回は、とれたまのコーナーで有名なテレビ東京さんの番組「ワールドビジネスサテライト」(以下、WBS)で紹介されるにあたって、どういう負荷対策をしたのかを紹介します。 WBSに紹介されて直後にサーバーアクセ […]

PicoPSU 120WI-25Vの効率を測定してみた

大変おひさしぶりのまつけん@TechBlogです。偶然ネタができたのでエントリーを。この後もエントリーが続くかどうかは謎です。 実は私が測定したわけではないのですが、PicoPS […]

クラッシュ&移行 ~Cerevo社内開発用サーバ構築記~

まつけんです。 Beagle Boardの記事が好評だったので、そのままなにかBeagleネタで行こうかとおもったのですが、本日、開発マシンが突然死したので、哀しみの開発マシン移行記を今回は書いてみます。 事の発端 土曜 […]

Beagle Board用 ツールチェインとAndroidの起動のおまけ

Cerevo まつけんです。 すこし間があいてしまいましたが、Beagle Board用第2弾をお送りしたいと思います。 今回は、BeagleBoard上で実行することが可能なバイナリが作成できるようになるための準備をし […]

Beagle Board 事始め

はじめまして。Cerevo まつけんです。 (2009-02-13追記) 下記の利用するシリアルケーブルの種類の説明で、Null Modem Cable=ストレートケーブルという記述になっていましたが、Null Mode […]

![Allwinner、Amlogic、Rockchipって知ってます?[24日目]](/wp-content/uploads/2017/12/IMG_20171224_230634.jpg)